Interpretabilidad vs. Causalidad ¿Son lo mismo?

¿Qué es la interpretabilidad?

En nuestro anterior artículo, 3 razones por las que la interpretabilidad está cobrando importancia en el mundo del aprendizaje automático, hablamos sobre la creciente importancia del concepto de interpretabilidad de un modelo en el mundo del machine learning o aprendizaje automático. ¿Pero a qué llamamos exactamente interpretabilidad?

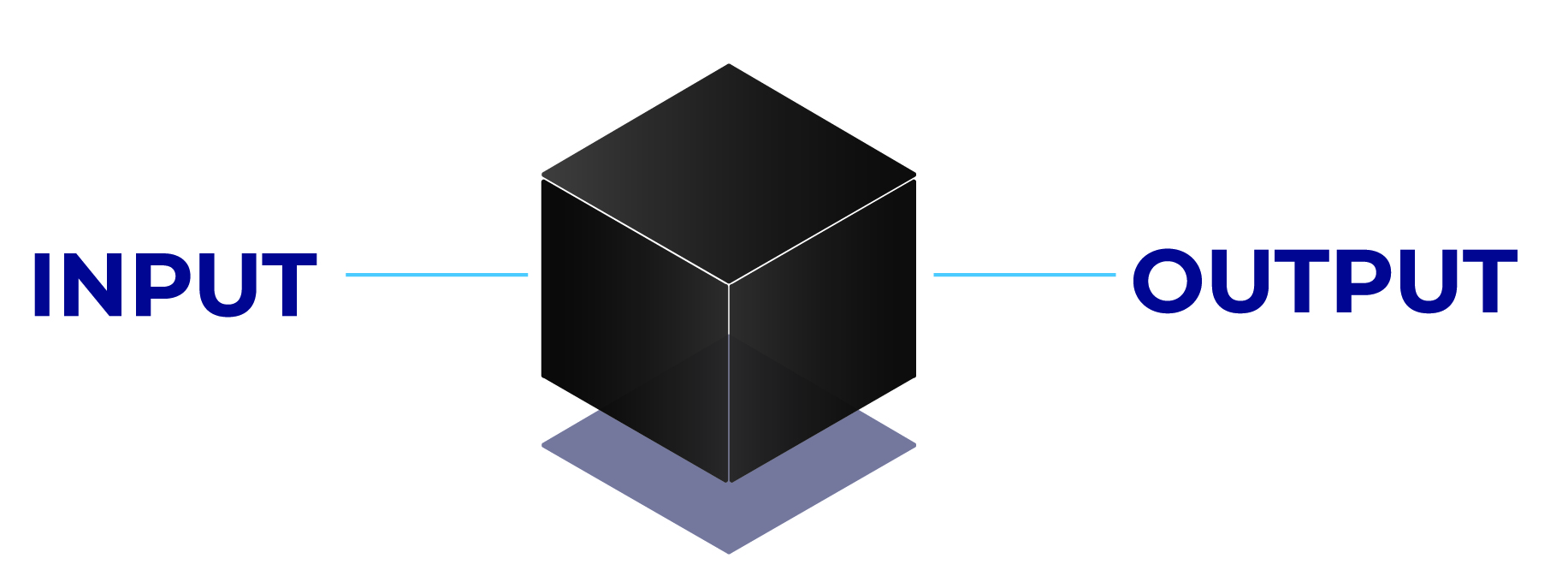

La interpretabilidad en el mundo del aprendizaje automático podría definirse como la capacidad de explicar los motivos por los que un modelo, una vez que recibe un determinado input o conjunto de datos, genera un determinado output o lista de predicciones. Esta aproximación es la opuesta al enfoque seguido mayoritariamente en el pasado a la hora de implementar modelos de machine learning, conocido como modelo “black box” o de caja negra:

El objetivo de los algoritmos para extraer interpretabilidad es precisamente convertir esa caja negra en un conjunto de explicaciones, reglas matemáticas o serie de inferencias que nos permitan entender por qué un modelo de aprendizaje automático toma unas determinadas decisiones, output, a partir de unos estímulos, input, concretos.

¿Qué es la causalidad?

La causalidad implica encontrar dos fenómenos o sucesos que tienen una relación de necesidad de concurrencia en un orden determinado, también llamada relación de causa y efecto. Es decir, supone encontrar un factor Y que lleva emparejado necesariamente la existencia de otro factor X que lo provoca.

Interpretabilidad vs. causalidad

Es muy común en el mundo del aprendizaje automático, incluso entre profesionales del sector, confundir el concepto de causalidad con otros como el de interpretabilidad o correlación, íntimamente ligados. Para demostrar la diferencia entre ambos conceptos, vamos a utilizar un ejemplo muy ilustrativo.

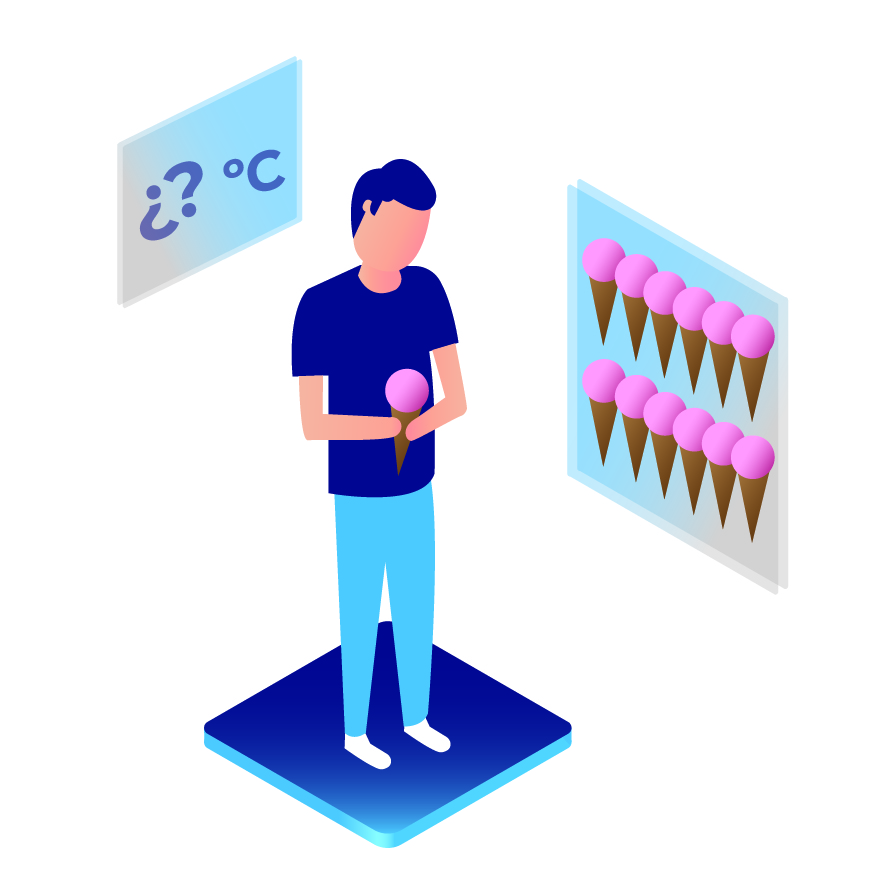

Supongamos que nuestro objetivo es crear un modelo de aprendizaje automático que prediga el volumen de golpes de calor que se van a producir el día de mañana en Madrid. Imaginemos también que entre los datos que utilizamos como input para nuestro modelo no tenemos la variable temperatura, pero sí una variable que cuantifica el consumo de helados en Madrid cada día. Si utilizamos algoritmos de interpretabilidad (ver 3 razones por las que la interpretabilidad está cobrando importancia en el mundo del aprendizaje automático) sobre nuestro modelo imaginario, es muy probable que la variable “consumo de helados” aparezca como la primera o una de las primeras en relevancia a la hora de explicar por qué nuestro modelo predice más o menos golpes de calor para un día determinado. A la vista de estos resultados, ¿podemos extraer la conclusión de que el consumo de helados es la causa de los golpes de calor en Madrid? Evidentemente no.

¿Qué ha pasado entonces? ¿Cuál ha sido el problema de nuestro razonamiento? La explicación es que no hemos tenido en cuenta la existencia de ciertos fenómenos estadísticos como pueden ser las correlaciones espurias, que se definen como:

Relación matemática en la cual dos acontecimientos no tienen conexión lógica, aunque se puede implicar que la tienen debido a un tercer factor no considerado aún, llamado factor de confusión o variable escondida.

En este caso, el factor de confusión o variable escondida es la temperatura, no incluida en el input del modelo, que es la verdadera causa que influye en el número de golpes de calor, pero que a la vez causa un aumento en el consumo de helados que es lo que nuestro modelo “ve”.

Interpretabilidad de modelos predictivos en el mundo sanitario

Como conclusión, podemos afirmar que es importante no confundir interpretabilidad con causalidad, especialmente en un área de gran sensibilidad y criticidad en la toma de decisiones como es el sector sanitario, pero aun así la interpretación de modelos de aprendizaje automático puede proporcionarnos información clínica o de gestión relevante, ayudando a generar conocimiento nuevo o detectar posibles líneas susceptibles de investigación.

En Sigesa hemos desarrollado nuestros propios algoritmos explicativos, mezcla de los métodos anteriores y desarrollos internos en el equipo de Machine Learning, para generar interpretabilidad de cada uno de nuestros modelos de ML, tanto Enara MLS como Enara MLP.

Para más información sobre nuestros modelos de aprendizaje automático o sobre cómo estos algoritmos pueden ayudarles a ganar interpretabilidad sobre sus predicciones, póngase en contacto con nosotros.